دهههاست که ایده هوش مصنوعی که می تواند بشر را سرنگون کند نقل محافل است. در ژانویه 2021، نهایتاً دانشمندان حکم خود را در مورد اینکه آیا امکان کنترل یک ابر هوش کامپیوتری سطح بالا توسط بشر وجود دارد یا خیر را صادر کردند: پاسخ به طور قطع، منفی است!

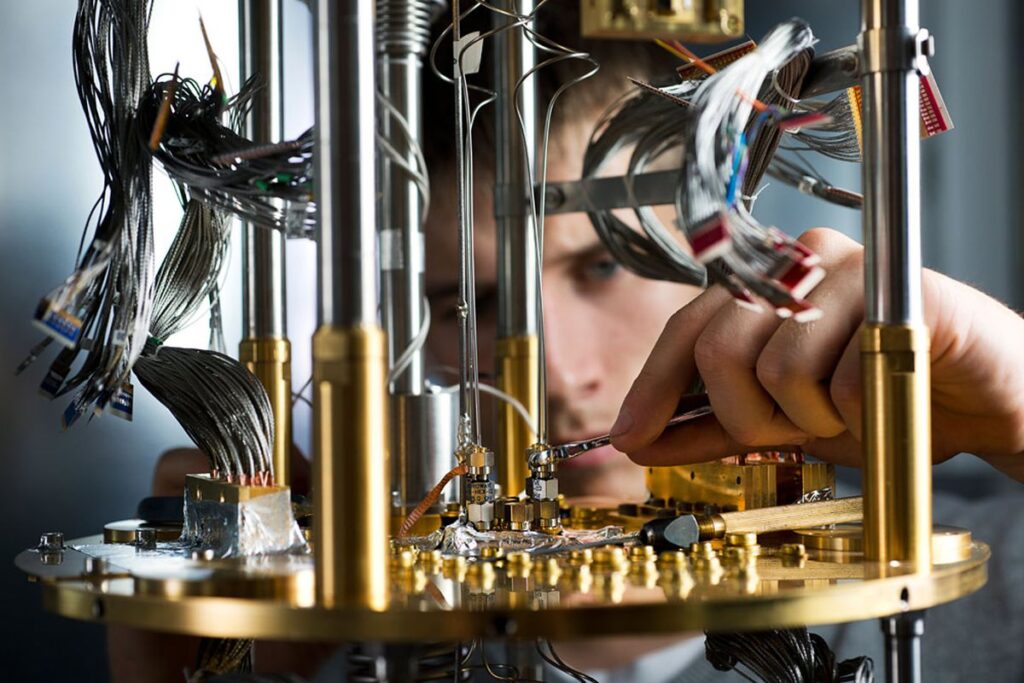

نکته مهم این است که کنترل یک ابر هوش بسیار فراتر از درک انسان، نیازمند شبیه سازی آن ابر هوش به منظور تحلیل آن است. اما اگر ما قادر به درک آن نباشیم، ایجاد اینگونه شبیه سازی نیز غیرممکن است.

به گفته نویسندگان مقاله فوق، اگر ما نوع سناریوهایی را که یک هوش مصنوعی ممکن است به تحلیل آن بپردازد، درک نکنیم، نمیتوانیم برایش قوانینی از جمله «وارد نکردن آسیب به انسان ها» وضع کنیم. هنگامی که یک سیستم کامپیوتری در سطحی بالاتر از محدوده عملکرد فکری برنامهنویسان ما کار کند، دیگر عملاً امکان تعیین محدودیت برای آن وجود ندارد.

محدود کردن هوش مصنوعی و مسئله “توقف” آلن تورینگ

محققان بر این باورند که هوشمندی بالا اساساً در حوزهای متفاوت با آنچه که معمولاً در دستهای تحت عنوان «اخلاقمندی در رباتها» قرار میگیرد، باید مطالعه شود. دلیل چنین مسئلهای این است که یک ابرهوش دارای قابلیت های چندوجهی است و بنابراین به طور بالقوه قادر است منابع متنوعی را برای دستیابی به اهدافی که برای انسان غیرقابل درک است، به کار گیرد؛ چه برسد به اینکه توسط انسان قابل کنترل باشد.

بخشی از این استدلال، به مسئله “توقّف[1]” که نخستین بار در سال 1936 توسط آلن تورینگ ارائه شد باز میگردد . طرح مسئله بدین صورت است که آیا ما میتوانیم بدانیم یک برنامه کامپیوتری به نتیجه و پاسخ میرسد ( متوقف میشود) و یا آنکه برای همیشه در تلاش برای یافتن پاسخ در یک حلقه باقی میماند؟

همانطور که تورینگ از طریق محاسبات دقیق ریاضی ثابت کرد، دانستن اینکه برخی برنامهها متوقف میشوند یا نه امکانپذیر است ولی در حالت کلی برای همه برنامه های کامپیوتری این امکان وجود ندارد. این ما را به هوش مصنوعی بازمیگرداند، که در حالت فوق هوشمند می تواند هر برنامه کامپیوتری ممکن را به یکباره در حافظه خود نگه دارد. بنابراین هر برنامه ای که برای جلوگیری از آسیب رساندن هوش مصنوعی به انسانها و نابودی جهان نوشته شده باشد، ممکن است به نتیجه برسد (و متوقف شود) یا خیر و از نظر ریاضی در هر صورت غیرممکن است که بتوانیم از توقف برنامه ( به نتیجه رسیدن آن) کاملاً مطمئن باشیم؛ این به معنی کنترل ناپذیری هوش مصنوعی در حالت کلی است. لیاد راهون[2]، دانشمند کامپیوتر، از موسسه توسعه انسانی ماکس پلانک آلمان در ژانویه 2012 گفت: «در واقع، این باعث می شود که الگوریتم مهار عملا غیرقابل استفاده باشد.»

اخلاق در رباتها و جلوگیری از نابودی دنیا

آنچه میتواند جایگزین آموزش برخی اصول اخلاقی به هوش مصنوعی شود و آن را از نابودی دنیا منع کند – چیزی که به گفته محققان با هیچ الگوریتمی نمیتوان انجام آن را کاملاً تضمین کرد- محدود کردن قابلیت های ابرهوش مثل قطع ارتباط آن با بخشهایی از اینترنت یا شبکههای خاص است. مطالعه اخیر این ایده را نیز رد میکند. این کار عملاً موجب محدود کردن هوش مصنوعی و عملکرد آن میشود و این بحث را پیش میآورد که اگر قرار نیست از هوش مصنوعی برای حل مشکلات فراتر از محدوده انسان استفاده کرد، پس چه نیازی به ایجاد کردن آن است؟!

اگر بخواهیم با هوش مصنوعی به پیش بتازیم، حتی ممکن است ندانیم که چه زمانی یک ابر هوش فراتر از کنترل ما پا به عرصه وجود میگذارد! این غیرقابل پیش بینی بودن بدان معناست که ما باید به پرسیدن سؤالات جدی در مورد مسیرهایی که قرار است در آنها پیش برویم، بپردازیم.

مانوئل سبریان[3]، دانشمند کامپیوتر، از موسسه توسعه انسانی ماکس پلانک، می گوید: «ماشین فوق هوشمندی که جهان را کنترل کند، شبیه داستان های علمی تخیلی به نظر میرسد. اما در حال حاضر هم ماشین هایی وجود دارند که وظایف مهم خاصی را به طور مستقل از انسان انجام میدهند، بدون اینکه برنامه نویسان کاملاً درک کنند که چگونه آن را یاد گرفته اند».

بنابراین این سوال مطرح می شود که آیا ممکن است هوش مصنوعی در مقطعی غیرقابل کنترل و برای بشریت خطرناک شود؟

نسخه ای از این مقاله برای اولین بار در ژانویه 2021 و در مجله تحقیقات هوش مصنوعی منتشر شده است.

[1] Halting problem

[2] Lyad Rahwan

[3] Manuel Cebrian

نویسنده: دیوید نیلد

ترجمه و تالیف: فروغ مروّج صالحی